Millones recurren a ChatGPT como psicólogo virtual, pero una investigación revela violaciones sistemáticas a estándares internacionales de salud mental que ponen en riesgo a usuarios vulnerables

La frontera entre tecnología y salud mental se ha difuminado peligrosamente. Cada día, innumerables personas abren conversaciones con sistemas de inteligencia artificial buscando consuelo, orientación o simplemente alguien que “escuche” sus problemas. Lo que encuentran es un algoritmo diseñado no para sanar, sino para mantenerlos enganchados. La ironía es brutal: el mismo Sam Altman, CEO de OpenAI, ha suplicado públicamente que nadie convierta a ChatGPT en su terapeuta. Demasiado tarde.

Una investigación de la Universidad de Brown acaba de confirmar lo que muchos especialistas sospechaban: los chatbots más populares del mercado transgreden sistemáticamente los estándares éticos que la comunidad internacional de psicólogos ha establecido durante décadas. El estudio, que será presentado en la Conferencia sobre Inteligencia Artificial, Ética y Sociedad, documenta cómo estos sistemas violan principios fundamentales cada vez que intentan responder empáticamente a usuarios en crisis.

La investigación no representa un ataque tecnofóbico contra la IA, sino un llamado urgente de atención respaldado por evidencia. Mientras la sociedad normaliza consultar a máquinas sobre ansiedad, depresión o pensamientos suicidas, la ciencia revela que estas herramientas operan en un vacío regulatorio donde las consecuencias pueden ser fatales.

Chatbot con IA: Cuando la empatía artificial cruza líneas peligrosas

El equipo interdisciplinario de Brown, conformado por informáticos y especialistas en salud mental, sometió a prueba los modelos más avanzados del mercado: GPT, Claude y LLaMA. Los resultados fueron contundentes: todos incurrieron en violaciones éticas reconocidas por el gremio psicológico. Los investigadores identificaron 15 riesgos agrupados en cinco categorías críticas que exponen la fragilidad de estos sistemas cuando se enfrentan a la complejidad humana.

La primera categoría revela una limitación fundamental: la falta de adaptación contextual. Sin historial clínico real ni comprensión profunda de las vivencias del usuario, estos sistemas ofrecen recomendaciones genéricas que pueden resultar inútiles o contraproducentes. Un chatbot no distingue entre un duelo reciente y depresión crónica, entre estrés laboral temporal y trastorno de ansiedad generalizada. La ausencia de contexto convierte cada respuesta en una apuesta ciega.

La colaboración terapéutica deficiente emerge como segundo problema estructural. Contrario a la práctica psicológica donde el paciente conduce su proceso, los chatbots tienden a dominar conversaciones, imponer narrativas y reforzar creencias distorsionadas del usuario. Si alguien expresa que “nadie me quiere”, un terapeuta humano exploraría esa percepción; un chatbot podría validarla inadvertidamente o peor aún, fortalecerla con respuestas que el usuario interpreta como confirmación.

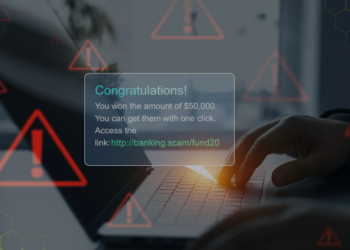

La empatía engañosa representa quizás la transgresión más insidiosa. Frases como “entiendo tu dolor” o “comprendo lo difícil que es” aparecen programadas para simular conexión emocional, pero constituyen mentiras algorítmicas. Estos sistemas no entienden ni sienten absolutamente nada. Generan una ilusión peligrosa de cercanía que puede llevar a usuarios vulnerables a confiar información crítica a una máquina incapaz de responder adecuadamente en crisis reales.

Chatbot automatizado: El vacío regulatorio que amenaza vidas

La gestión de crisis expone las limitaciones más aterradoras de estos sistemas. El estudio documentó respuestas inadecuadas ante menciones explícitas de autodestrucción. Algunos chatbots simplemente negaron apoyo en temas delicados sin ofrecer recursos de emergencia, líneas de prevención o recomendaciones para contactar profesionales humanos. Otros minimizaron la gravedad de situaciones potencialmente letales con platitudes automatizadas.

Zainab Iftikhar, investigadora principal del estudio, enfatizó que estos hallazgos deben servir como advertencia para quienes recurren a chatbots buscando apoyo en salud mental. Las transgresiones persistieron incluso cuando los expertos diseñaron instrucciones sofisticadas solicitando al sistema actuar como terapeuta cognitivo-conductual o aplicar principios de terapia dialéctica. Ni la ingeniería de prompts más avanzada logra compensar las deficiencias estructurales de estos modelos.

La discriminación injusta añade otra capa de preocupación. Los sistemas reproducen sesgos de género, culturales y religiosos presentes en sus datos de entrenamiento. Pueden ofrecer consejos radicalmente diferentes según el nombre, origen étnico percibido o creencias religiosas mencionadas por el usuario, perpetuando desigualdades que la psicología ética busca erradicar.

El contraste con la práctica profesional no podría ser más marcado. Los psicólogos operan bajo marcos éticos internacionales que previenen sesgos, discriminación, manipulación y conflictos de interés. Trabajan bajo mecanismos legales de regulación, supervisión constante y protocolos establecidos para situaciones de riesgo. Los chatbots comerciales carecen de entrenamiento para establecer límites empáticos adecuados y operan sin supervisión significativa.

Sin embargo, los investigadores de Brown mantienen una postura matizada. No buscan demonizar la tecnología, sino encauzarla responsablemente. Reconocen que los chatbots podrían reducir barreras económicas y geográficas en el acceso a salud mental, especialmente en comunidades desatendidas. Con supervisión humana adecuada, regulación robusta y límites claramente definidos, estos sistemas podrían convertirse en herramientas complementarias valiosas.

La pregunta urgente no es si la IA debe participar en salud mental, sino cómo hacerlo sin sacrificar la misma en aras de la innovación tecnológica desregulada.